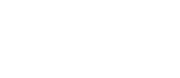

Η Microsoft ανακοίνωσε το Maia 200, τον διάδοχο του πρώτου in-house AI chip της, Maia 100, παρουσιάζοντάς το ως νέο AI accelerator για μεγάλης κλίμακας φόρτους εργασίας.

Η εταιρεία αναφέρει ότι το Maia 200 κατασκευάζεται με τη διεργασία 3nm της TSMC και στοχεύει να καλύψει ανάγκες τόσο εκπαίδευσης όσο και inference για τα μεγαλύτερα μοντέλα που φιλοξενούνται στις υπηρεσίες της.

Σύμφωνα με τη Microsoft, το Maia 200 έχει «τριπλάσια απόδοση FP4 σε σχέση με την τρίτη γενιά Amazon Trainium» και προσφέρει «υψηλότερη απόδοση FP8 από την έβδομη γενιά TPU της Google». Η σύγκριση αυτή εντάσσεται σε μια πιο άμεση αντιπαραβολή με τους μεγάλους ανταγωνιστές της στο cloud, σε αντίθεση με το 2023, όταν η Microsoft είχε παρουσιάσει το Maia 100 χωρίς να επιδιώξει άμεσες συγκρίσεις με τις AI δυνατότητες cloud της Amazon και της Google.

Κάθε chip Maia 200 διαθέτει περισσότερα από 100 δισεκατομμύρια τρανζίστορ, τα οποία έχουν σχεδιαστεί ώστε να διαχειρίζονται μεγάλης κλίμακας AI workloads. Ο Scott Guthrie, εκτελεστικός αντιπρόεδρος του τμήματος Cloud and AI της Microsoft, δήλωσε ότι το Maia 200 μπορεί να τρέξει τα μεγαλύτερα μοντέλα της σημερινής εποχής, διατηρώντας παράλληλα σημαντικό περιθώριο για ακόμη μεγαλύτερα μοντέλα στο μέλλον.

Η Microsoft σκοπεύει να αξιοποιήσει το Maia 200 για τη φιλοξενία του GPT-5.2 της OpenAI, καθώς και άλλων μοντέλων για το Microsoft Foundry και το Microsoft 365 Copilot. Ο Guthrie υπογράμμισε επίσης ότι πρόκειται για το πιο αποδοτικό σύστημα inference που έχει αναπτύξει ποτέ η Microsoft, με 30% καλύτερη απόδοση ανά δολάριο σε σχέση με την πιο πρόσφατη γενιά hardware που διαθέτει σήμερα στο στόλο της.

Την πρώτη χρήση των νέων chips θα αναλάβει η ομάδα Superintelligence της Microsoft. Παράλληλα, η εταιρεία ανοίγει πρώιμη πρόσβαση σε ακαδημαϊκούς, developers, AI labs και contributors έργων open-source μοντέλων, προσκαλώντας τους σε early preview του Maia 200 software development kit.

Σε επίπεδο υποδομών, η Microsoft ξεκινά να αναπτύσσει τα Maia 200 από σήμερα στην περιοχή Azure US Central, με επιπλέον περιοχές να ακολουθούν. Την ίδια στιγμή, όπως σημειώνεται από την εταιρεία, τόσο η Google όσο και η Amazon εργάζονται σε next-generation AI chips, ενώ η Amazon αναπτύσσει συνεργασία με τη Nvidia για να ενσωματώσει το επερχόμενο Trainium4 με NVLink 6 και την αρχιτεκτονική rack Nvidia MGX.

Πηγή: https://www.insomnia.gr/

(Κώστας Παπαζαχαρίου, αναδημοσίευση 29/1/2026)

Join the Conversation →